O suicídio assistido é autorizado em vários países. Na Suíça tal é permitido desde a década de 1980. Para um assunto tão crítico como este, os critérios são bastante apertados sendo um dos principais, a necessidade da pessoa que deseja morrer ser avaliada psicologicamente, como estando na posse das suas faculdades mentais de decisão.

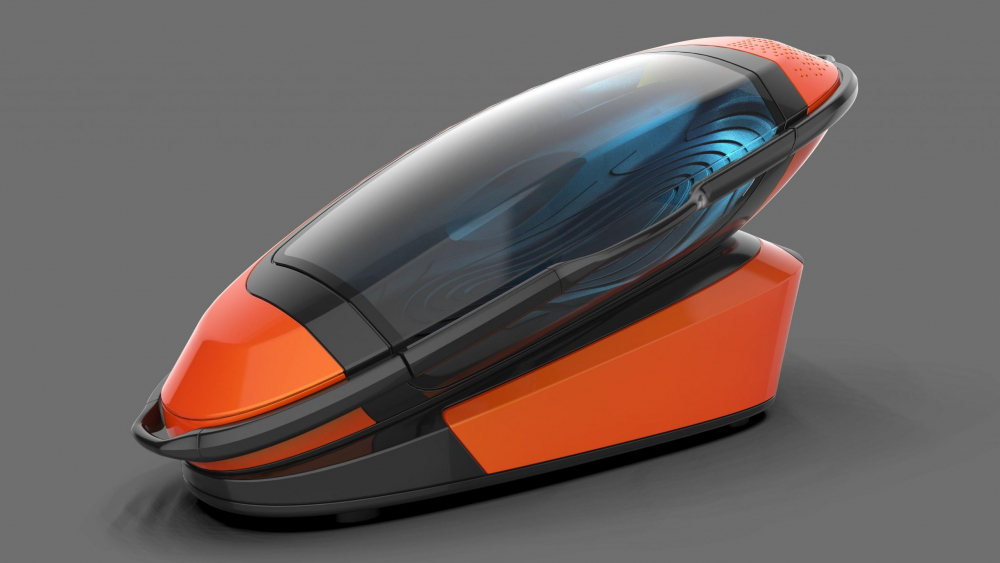

Mas há dimensões complexas neste problema, já que o suicídio assistido implica o envolvimento de várias pessoas para que a pessoa possa consomar esse desejo. Recentemente foi aprovada uma cápsula de suicídio, que elimina parte do envolvimento de terceiros, deixando as pessoas que escolheram morrer dessa forma, tomar a decisão do momento em que o pretendem concretizar.

Mas persiste o envolvimento na avaliação psicológica que é feita da capacidade mental. Recentemente foi proposta uma possível solução, para que essa avaliação psicológica possa ser feita por uma inteligência artificial (IA), eliminando assim o elemento humano dessa componente.

Mas será que isso resolve o problema moral? Na verdade, há fortes opositores a que um algoritmo seja determinante na concretização da decisão de morte de um paciente. Sendo certo que a IA já é hoje usada em muitas situações de decisão médica, não tem sido aplicada em assuntos de justificação moral. Segundo os opositores, a ação da inteligência artificial deve ser canalizada para situações de avaliação clínica complexa e não para decisões de índole moral. E levantam algumas questões. Qual a forma de construir estes algoritmos? Como se pode garantir que estão corretos e mesmo quando parecem corretos, há enviesamentos conhecidos?

No que diz respeito à morte, parece que as pessoas não confiam nas máquinas, mas também parece que não confiam nos humanos.

Crédito foto: MIT